我们使用 Dify 作为 LLM APP 开发平台。其直观的界面结合了 AI 工作流、RAG 管道、代理功能、模型管理、可观察性功能等,使从原型到生产的应用程序创建成为可能。以下是核心功能的列表:

1. 工作流: 在可视化画布上构建和测试强大的 AI 工作流,利用以下所有功能及其他功能。

2. 全面的模型支持:与来自数十家推理提供商和自托管解决方案的数百种专有/开源 LLM 无缝集成,涵盖 GPT、Mistral、Llama3 和任何兼容 OpenAI API 的模型。支持的模型提供商的完整列表可在此处找到。

3. 提示 IDE:用于制作提示、比较模型性能以及向基于聊天的应用程序添加文本转语音等其他功能的直观界面。

4. RAG 管道: 广泛的 RAG 功能,涵盖从文档提取到检索的所有内容,开箱即用,支持从 PDF、PPT 和其他常见文档格式中提取文本。

5. 代理功能:您可以基于 LLM Function Calling 或 ReAct 定义代理,并为代理添加预构建或自定义工具。Dify 为 AI 代理提供了 50 多种内置工具,例如 Google Search、DALL·E、Stable Diffusion 和 WolframAlpha。

6. LLMOps: 随着时间的推移监控和分析应用程序日志和性能。您可以根据生产数据和注释不断改进提示、数据集和模型。

7. 后端即服务:Dify 的所有产品都带有相应的 API,因此您可以毫不费力地将 Dify 集成到您自己的业务逻辑中。

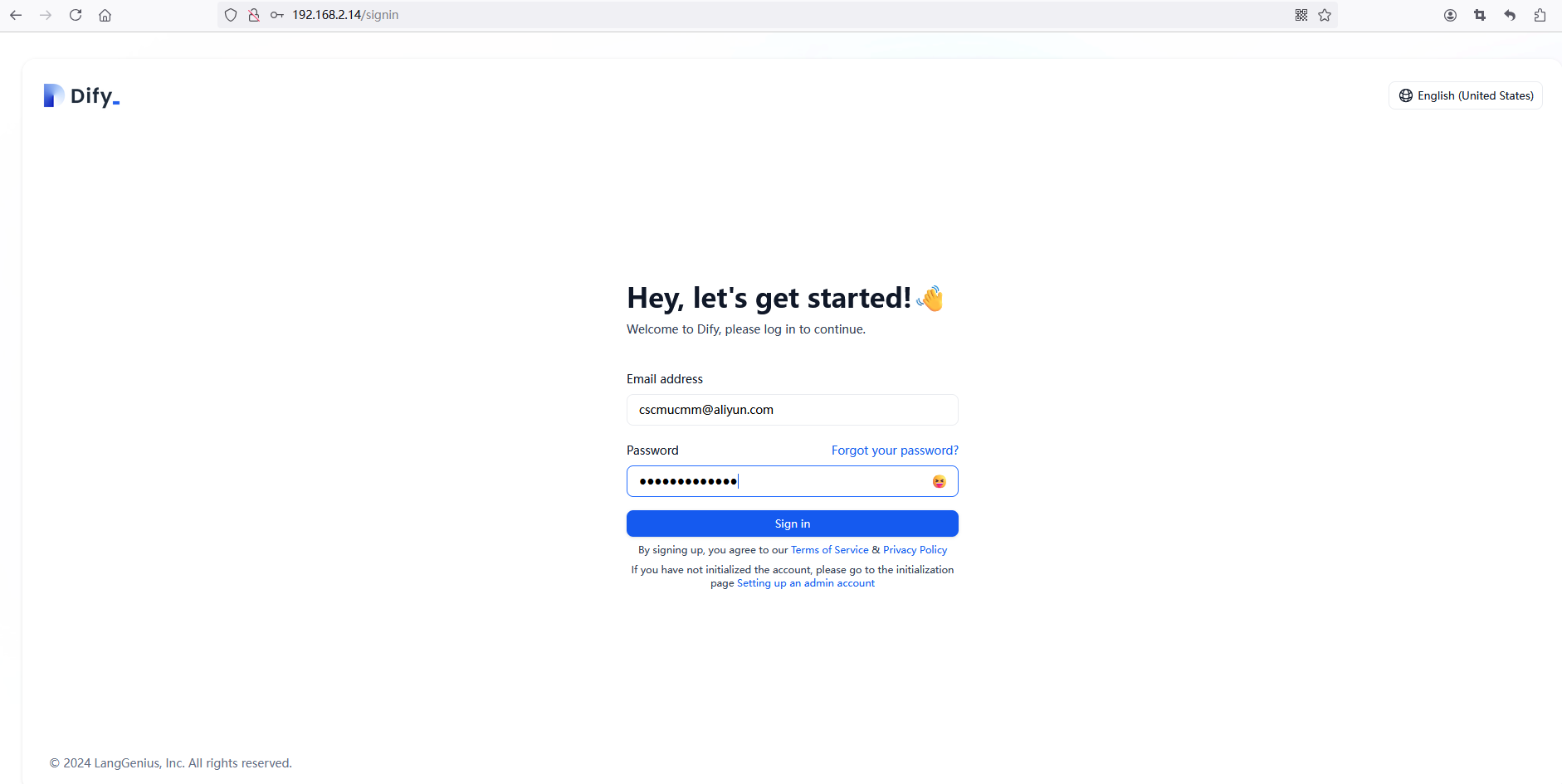

下面演示如何增加大语言模型。打开登录页面并输入访问安装页面 http://localhost/install 设置系统时输入的管理员帐户电子邮件地址和密码

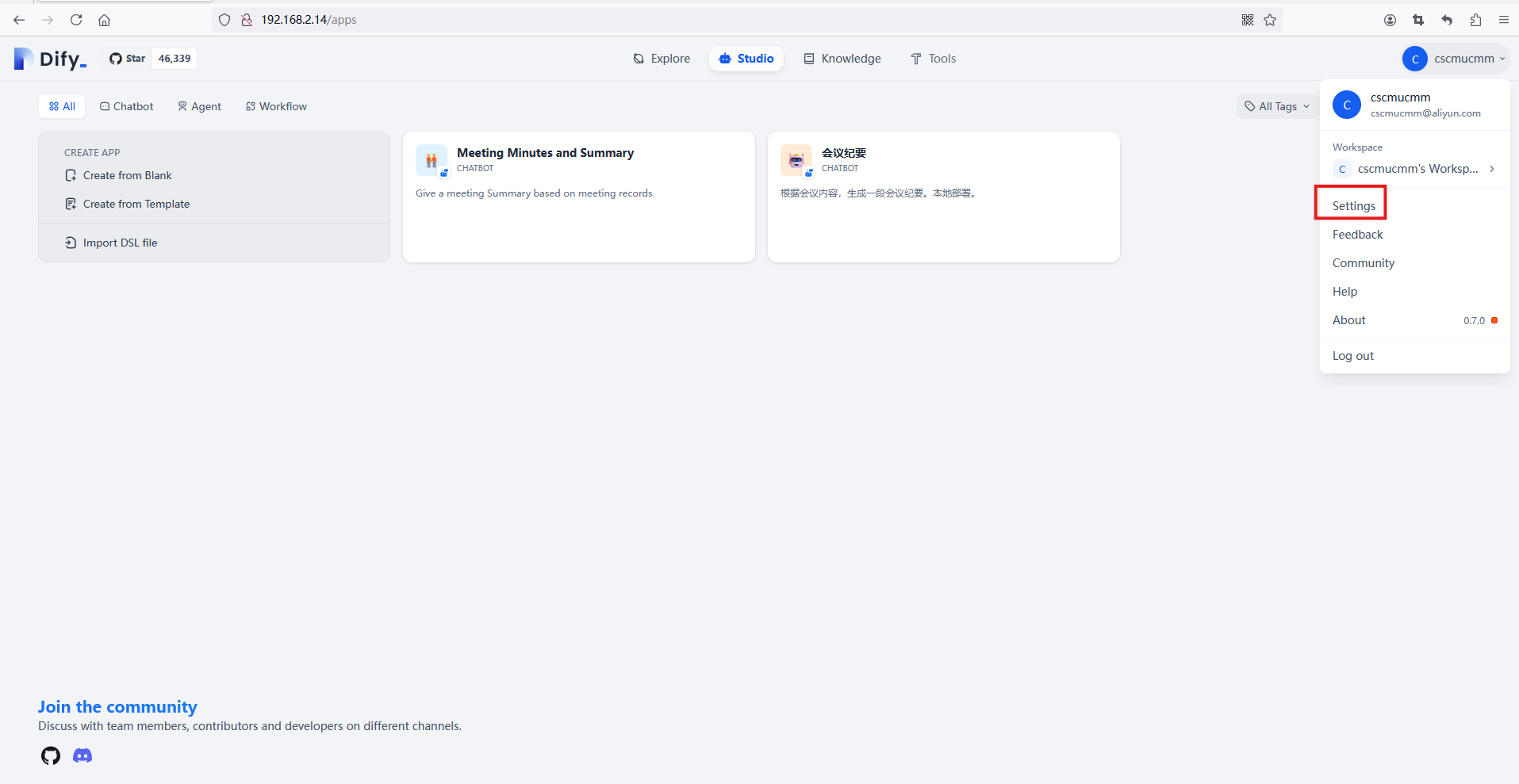

然后点击“登录”按钮进入系统,现在,您需要设置系统以添加大型语言模型,点击右上角并点击设置。

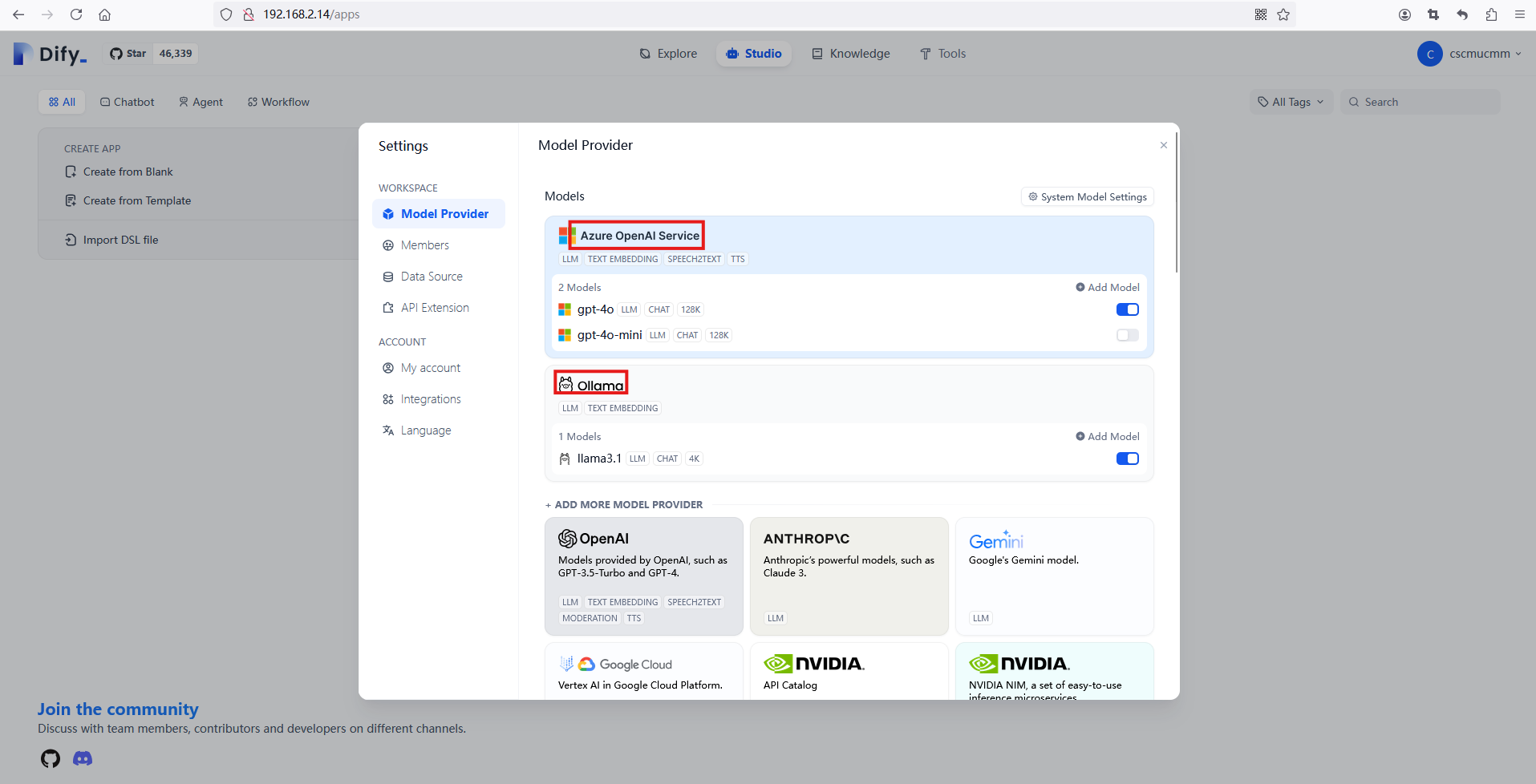

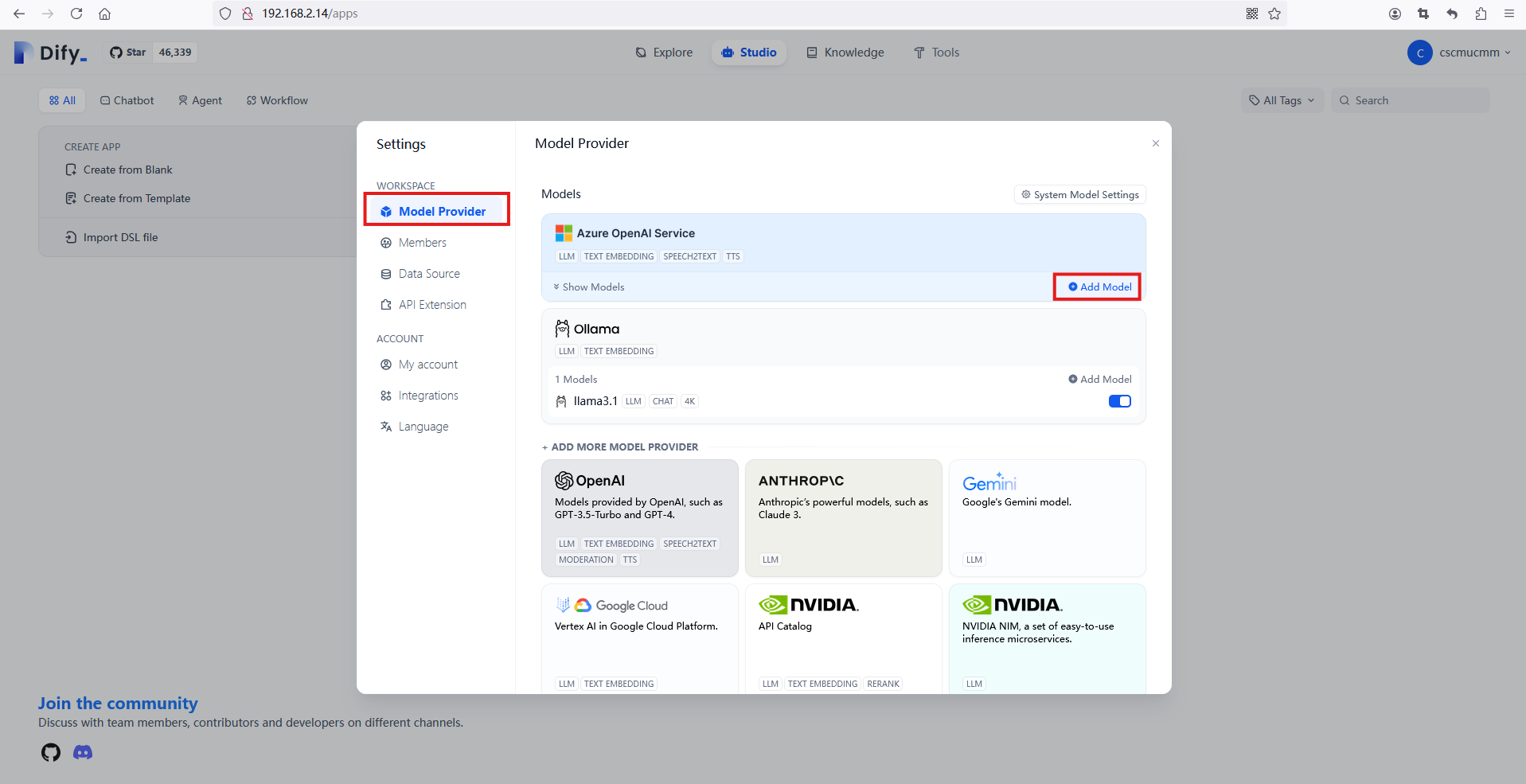

这将带您进入设置窗口。在窗口中,单击左上角的“模型提供程序”条目以显示与 dify 兼容的模型,然后将鼠标悬停在模型部分,直到看到“添加模型”按钮出现,然后单击它以添加 LLM 模型。

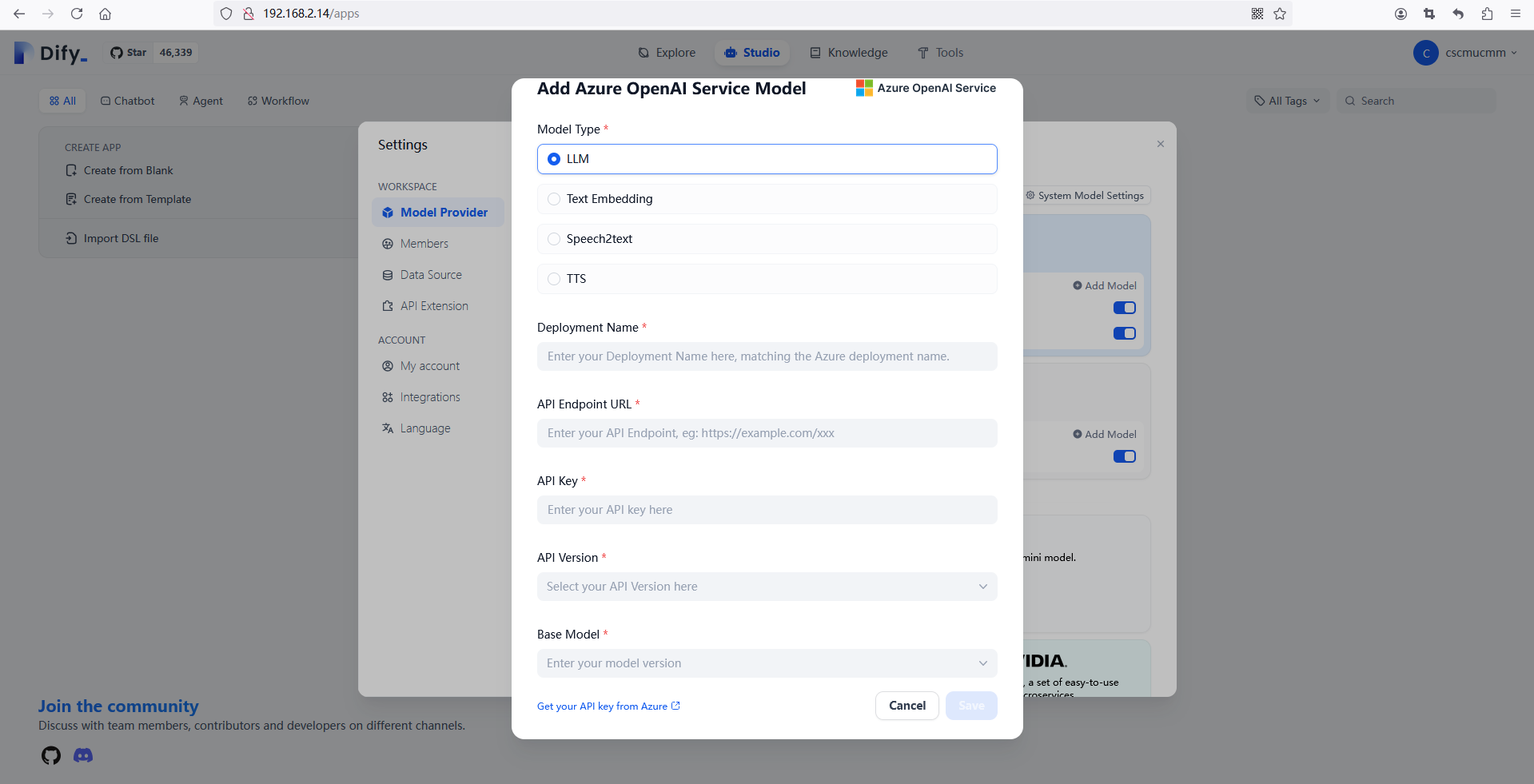

这里我们以 Azure OpenAI 为例,单击“Azure OpenAI 服务”部分中的“添加模型”按钮后,将进入“添加 Azure OpenAI 服务模型”窗口。

现在,您需要在必填数据字段中输入模型信息,

Model Type == “LLM”

Deployment Name ==”……”

API Endpoint URL == “……”

API Key == “……”

API Version == “……”

Base Model == “……”

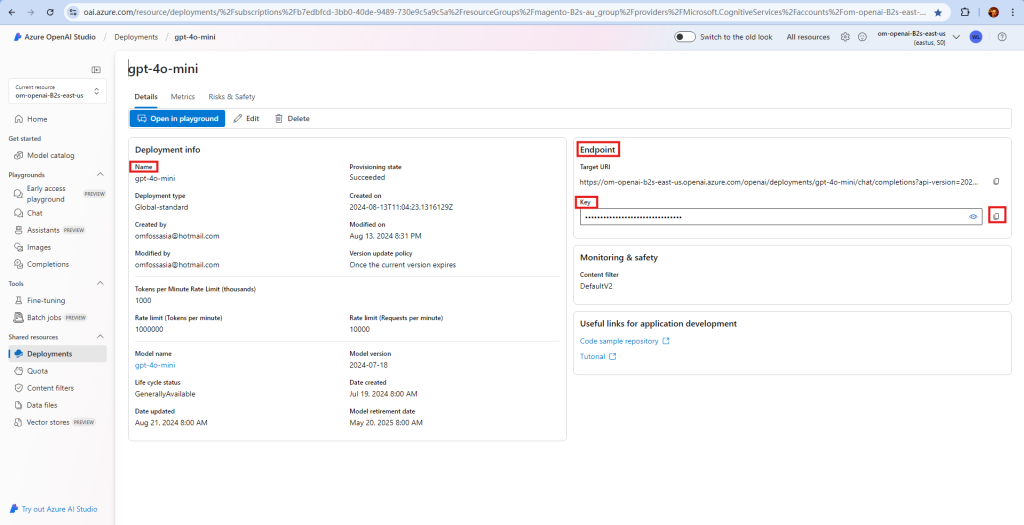

然后你需要打开 Azure OpenAI Studio 来获取“部署名称”、“API 端点 URL”、“API 密钥”。在使用 Azure OpenAI 服务之前,你需要创建部署。

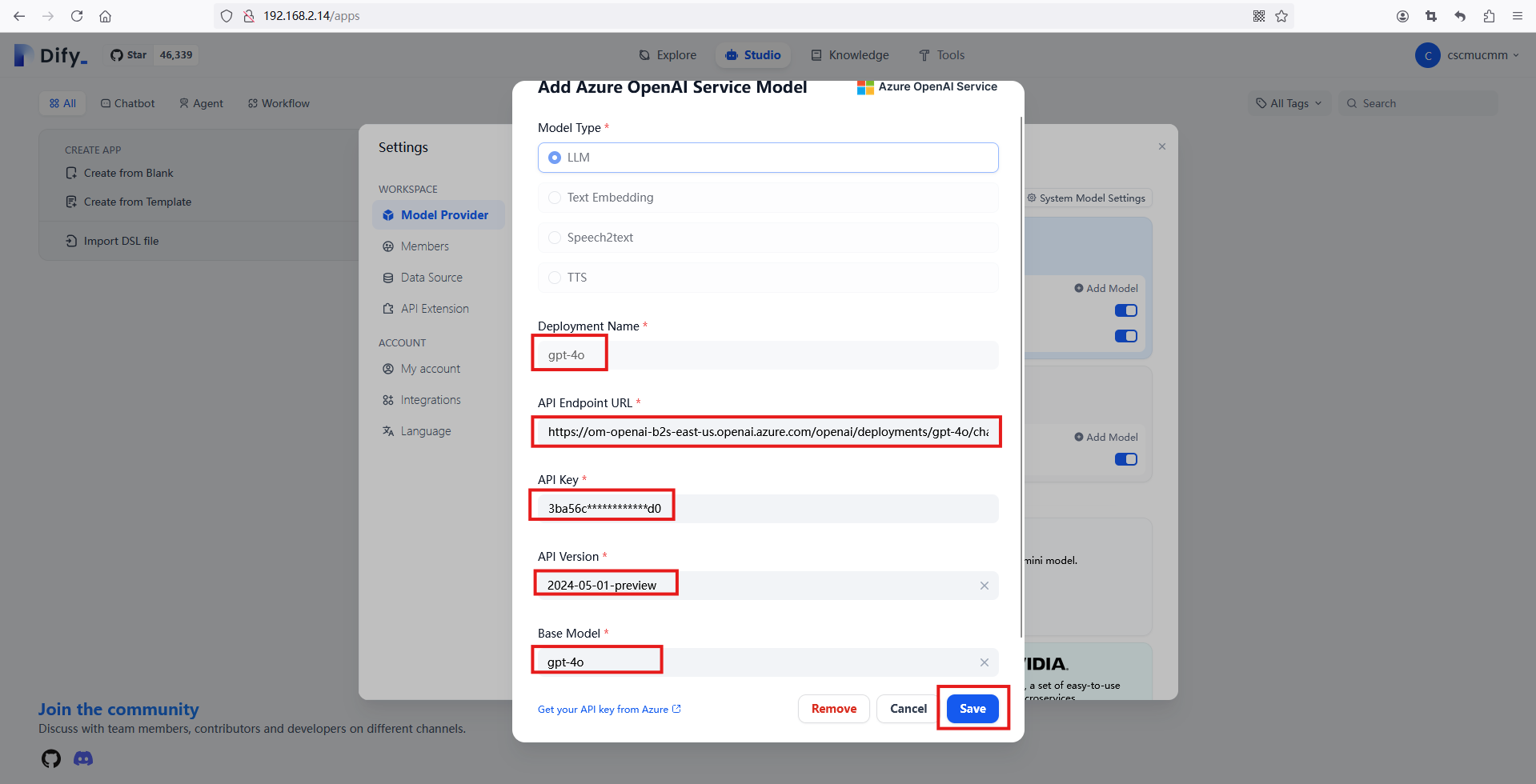

输入您从 Azure OpenAI Studio 获取的上述数据。当您将 API 密钥复制到 Dify 时,您的 API 密钥将使用 PKCS1_OAEP 技术加密和存储。

对于 API 版本和基本模型,您需要从下拉框中选择,在此示例中我们设置的值如下:

API Version == 2024-05-01-preview

Base Model == gpt-4o

然后点击“保存”。

恭喜!您刚刚添加了一个模型,并且可以添加多个模型,包括开源 AI 模型,例如可以在笔记本电脑上部署的 Ollama。